LABOR #2

MOTIONTRACKING – KÖRPER UND BEWEGUNG AUF DER BÜHNE

// MIT CHRIS ZIEGLER

1.8.–5.8.2022 in Berlin

Werkstattbericht von Ronja Lena Dörr

Von Positiontracking über Motionsensing bis hin zu Motiontracking auf der Bühne: In Labor#2 gingen die Laborant*innen der Frage nach, wie Multimedia – in Kombination von Soft- und Hardware – auf der Bühne eingesetzt werden kann, um Körper und Bewegung digital zu erfassen und in den Raum zu übersetzen.

Chris Ziegler, Medienkünstler und Szenograf für immersive Räume, hat sich Anfang August mit einer kleinen Gruppe Laborant*innen aus unterschiedlichen Arbeitsfeldern (Bühnenbild, Regie, Inspizienz) in den Räumen des DOCKdigital ins Labor #2: “Motiontracking – Körper und Bewegung auf der Bühne“ begeben. Mehr über Chris Ziegler erfahrt ihr im Gespräch mit Theaterwissenschaftlerin Birgit Wiens.

Seit 2022 ist der ausgebildete Architekt Mitglied des DOCKdigital Motiontracking Lab Berlin. Dort ist er vor allem im Bereich Musiktheater und Tanz tätig. Ziegler schafft Multimedia Anwendungen, die er als lebendige Raumchoreografien bezeichnet. Für den Dialog zwischen immersivem Bühnenbild und Publikum.

VJ-Toolkit fürs Positiontracking: Tracken von Bewegung auf der Bühne

Die Teilnehmenden der Anfängerrunde, wurden von Chris Ziegler zu „Video Jockeys“ in der Software ISADORA ausgebildet: Isadora ist eine grafische Programmiersoftware, die Digitalkünstler*innen eine einfache Benutzeroberfläche bietet, um Video Projection Mapping und Video Tracking für Tanz, Theater oder Oper zu erlernen oder interaktive Designs mit benutzerdefinierten Schnittstellen für VJ-Events zu erstellen.

Die Teilnehmenden lernten das Einmaleins des Multimedia-Programmierens, um so/damit eigene interaktive Projekte realisieren zu können. Inputs wie Live-Video, Sound oder Bewegungsinformationen werden in die Software eingespeist und die selbst programmierte Multimedia Steuerung liefert den Output. Über einfachste Multimediamittel wie Maus, Sprache oder Live-Kameras, lernten die Teilnehmenden mithilfe der Software Dynamik auf der digitalen Bühne herzustellen. Das interaktive Softwaretool mit Schwerpunkt auf Echtzeitmanipulation digitaler Videos eröffnet den Workshopteilnehmenden die Möglichkeit digital künstlerisch aktiv zu werden.

Man muss nicht zum Sklaven der Technik werden, sondern kann die Steuerung für sich nutzen!

Chris Ziegler

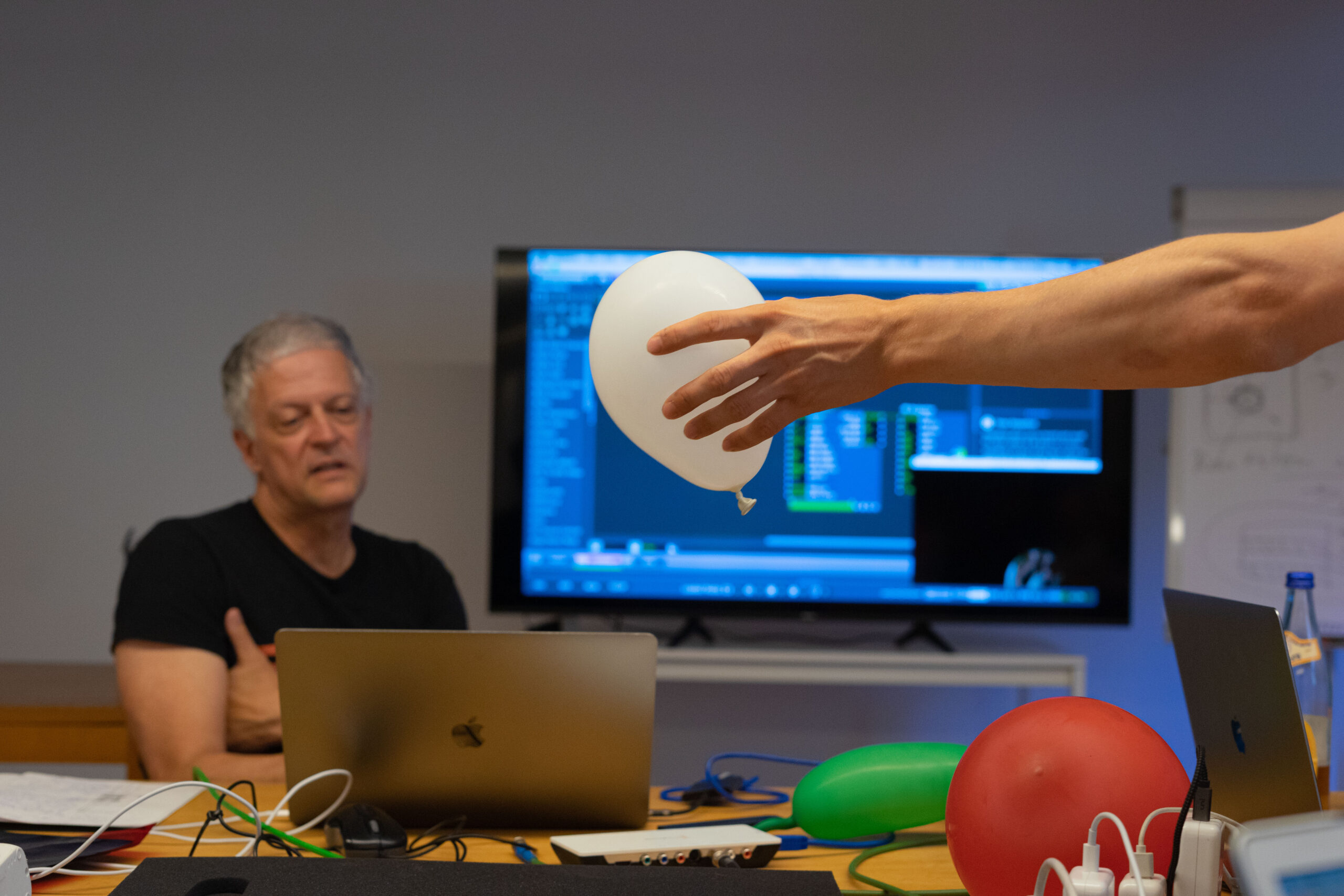

Motion Capturing: Vernetzung von Bühne und Bewegung

Die Spielidee von Trackingmethoden ist die Vernetzung von realer Raumbühne und physischer Aktion. So können Schauspielende oder auch das Publikum von außen auf das Geschehen Einfluss nehmen. Vom Position Tracking mit DIY-Infrarot-Überwachungskameras bis hin zu Übungen zum Motion Sensing mit der Kinect-Kamera für Tiefenraumtracking: Chris Ziegler hatte für den Fortgeschrittenenkurs noch einiges in Petto. Die Teilnehmenden konnten jetzt auf ihr Isadora-Know-how aufbauen und Bewegung von Körpern auf der Bühne in den digitalen Raum übersetzen. Motion Capturing bietet die Möglichkeit, menschliche Bewegungen zu animieren. Zur Aufnahme und Verarbeitung von Bewegungsinformationen nutzten die Teilnehmenden beispielsweise die Tiefenrauminformation (Bilddaten) einer Kinect IR Kamera.

Die Bühne als Raumchoreografie von Licht, Ton, Sprache und Bewegung wird dynamisch und fliessend.

Um den mediale Raumchoreografien entstehen zu lassen, müssen Geschwindigkeiten und Bewegungsrichtungen der Agierenden ermittelt werden. Chris Ziegler demonstriert das selbst gebautes Motionsensing System Corpus (2011), das durch am Körper angebrachte Sensoren Ton und Licht durch Bewegung auf der Bühne generiert. Die Sensoren messen die Bewegungsrichtung und die Bewegungsqualität eines Körpers wie zB. Beschleunigung oder Abbremsen. Damit lernt ein Tänzer/Schauspieler intuitiv Musik und Licht selbst zu steuern. Mittlerweile besitzt jedes handelsübliche Smartphone hochentwickelte Sensoren, die dafür genutzt werden können. Vom Gyroscope, einem Drehsensor, der die Lageveränderung des Körpers misst über Acceleration Sensoren, die Geschwindigkeiten im Raum delektieren, bis hin zu Kompass- oder Höhensensoren und GPS.

Szenograf*innen sind die Schnittstelle zwischen Technik und Kunst.

Kerstin (Teilnehmerin)

Echtzeit Charakter Animation mit Rokoko Motion Tracking Anzug

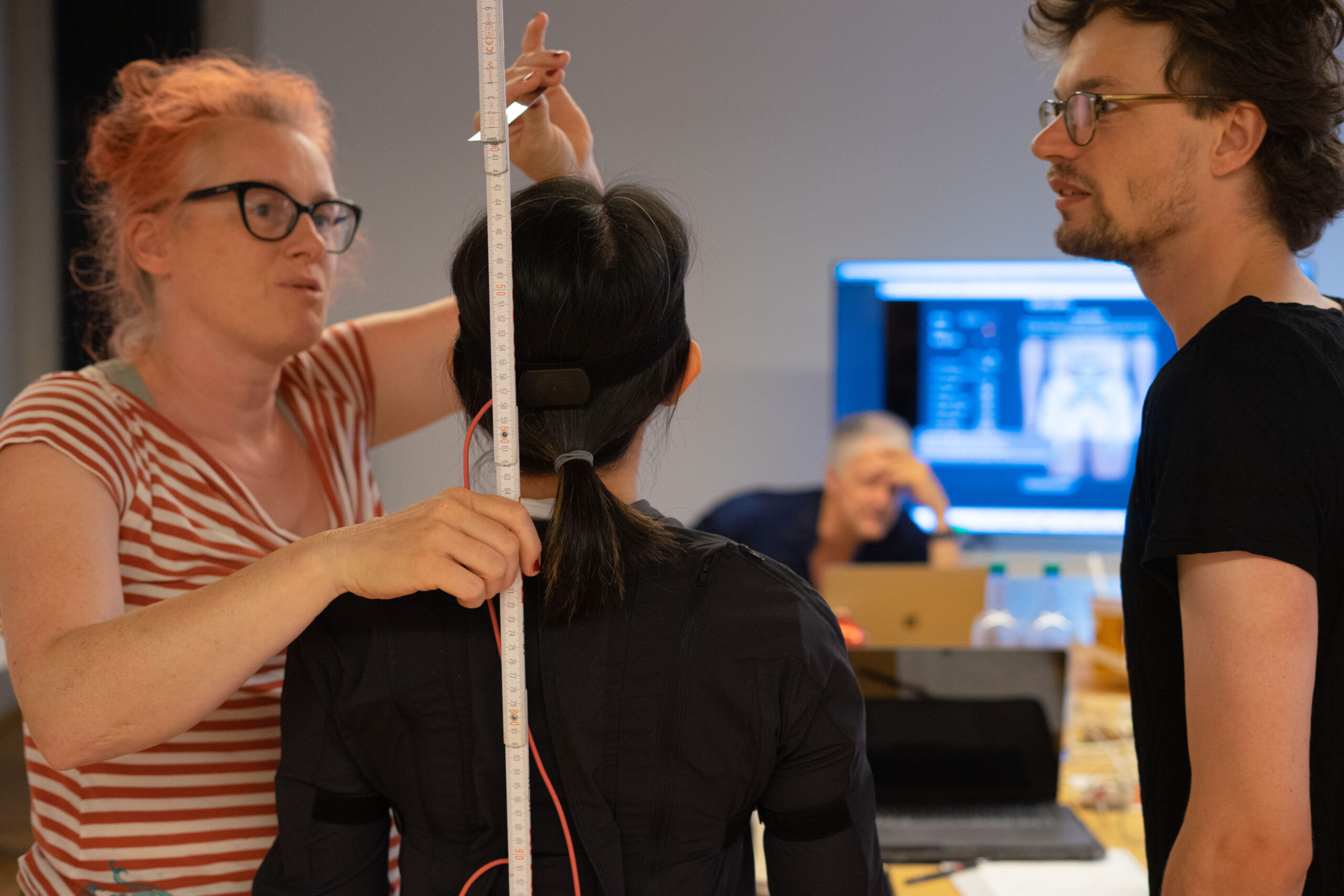

Wie können 3D-Animationen, virtuelle Charakteren oder Avatare in einer digitalen Realität (mit Schauspielenden inter-)agieren? Die Gruppe probiert sich unter Chris Zieglers Anleitung am Motiontracking in VR: Sie bauen und animieren 3D Avatare. Teilnehmerin Ophelia steigt in den Rokoko Motion Tracking Anzug. Das Kabelsystem im Anzug sammelt über Sensoren an zentralen Punkten des Körpers ihre Bewegungsdaten. Über einen Sender werden die Daten via W-Lan an den Computer übertragen und live weiterverarbeitet. So können Bewegungen schnell auf das digitale Abbild übertragen werden.

Calibration Reset > Stand still > Ready! Move!

Die animierte Figur hakt hier und da etwas, aber Ophelias rudimentären Bewegungen sind auf dem Bildschirm zu sehen. Das System übersetzt die Bewegungsinformation, die aus dem Koordinatensystem des Anzugs berechnet wird auf die digitale Figur. Und die kann hier und da etwas ungenau sein, je nach „Fit“ des Anzugs.

Um Abbildungsfehler zu vermeiden sollte auch das Kabelsystem im Anzug unversehrt sein. Die Teilnehmenden erschaffen nach ihrem Ebenbild eigene Avatare im Character Creator und animieren sie in iClone. Da Ophelia noch im Anzug steckt, wird aufbauend auf den Avatar ein Actor Profile angelegt. Dazu wird sie von Kopf bis Fuß vermessen. Mit den eingespeisten Größendaten kann ihr Character realitätsnah animiert werden.

Die Übersetzung funktioniert auch ganz gut. Hier und da knickt mal ein Bein etwas ungünstig ein, aber im Großen und Ganzen wedelt da eine zweite Ophelia im virtuellen Raum mit den Armen. Ophelias Gesichtszüge werden mit einer Facetracking-App ins System gespeist und schon kann ihr Avatar durch Lippenbewegungen oder Gesichtsausdrücke mit dem Rest der Gruppe kommunizieren.

Der Rokoko Motiontracking Anzug ist auch mit der Software Isadora kompatibel. Designkünstler*innen können hier mit der „Skeleton Decoder“-Anwendung kunstvolle Abstraktionen aus den Bewegungsdaten des Motiontracking Anzugs kreieren.

Theaterleute sollen auch die Logik hinter den neuen Medien erfassen, um effizient neue Räume und Kommunikationsmedien bauen zu können.

Chris Ziegler

So, das wars – der Rest liegt bei euch!

Durch Aneignen dieser Mittel bilden wir uns Stück für Stück selbst aus und erweitern unseren beruflichen Gestaltungsradius. „Ich habe versucht klarzumachen, dass alle Lösungen im digitalen Bereich sehr individuell und prototypisch sind und nicht standardisiert kopiert werden können. Die technischen Möglichkeiten entstehen gerade erst. Jeder muss selbst ausprobieren, welche Werkzeuge für ihn funktionieren und sich ein eigenes Repertoire anlegen.“

Chris Ziegler hat in Labor#2 eine enorme Spannweite vom multimedialen Resampling von Events bis hin zur Arbeit mit XR-Avataren bedient. Nach diesem Überblick über die technischen Einsatzmöglichkeiten, liegt die kreative Zusammenführung der multimedialen Möglichkeiten des Position- bis Motion Tracking mit dem Bühnenbild nun bei den Laborant*innen.

Wann: 1.8. – 5.8.2022

Was: “Motiontracking – Körper und Bewegung auf der Bühne“

Dozent: Christian Ziegler (Medienkünstler, Szenograf für immersive Räume)

Ort: Berlin, Kastanienallee 79

Kooperationspartner: DOCKdigital

Zeit Einsteiger*innen: 1. – 2.8.2022

Zeit Fortgeschrittene: 3. – 5.8.2022

Kosten: 120€ Einsteiger*innen, 140€ Fortgeschrittene