Chris Ziegler spricht mit Theaterwissenschaftlerin Birgit Wiens über die Herausforderung, Bühnen zwischen materiellen, theatralen und virtuellen Räumen zu gestalten

Künstlerisches Arbeiten und Experimentieren mit Digitalmedien im Theater ist – auch wenn hierzulande in der Breite bisher kaum etabliert – keineswegs neu. Davon erzählt etwa Steve Dixons Kompendium Digital Performance. A History of New Media in Theater, Dance, Performance Art, and Installation (MIT Press 2007). Auch Chris Ziegler, darin erwähnt, ist Akteur dieser „Geschichte“: Seit über 20 Jahren forscht er an interaktiven Systemen für Bühnen und ist, auch international, in verschiedenen Konstellationen tätig. In unserer Labor-Reihe leitet er das Labor „Motiontracking – Körper und Bewegung auf der Bühne“. Wie sieht er den Stand der Diskussion?

Gestartet bist Du in den 1990ern am ZKM Karlsruhe und bekannt geworden durch Deine Mitarbeit als Designer an William Forsythes digitalem Trainingswerkzeug für Tänzerinnen „Improvisation Technologies“ (1999) und zudem bald durch eigene Projekte. ‚Wie kann man als Tänzerin den eigenen Körper in den virtuellen Raum mitnehmen?‘, hat als Frage damals viele beschäftigt (1). Gibt es einen ‚roten Faden‘ in Deiner Arbeit, und inwiefern verstehst Du sie als szenografisch?

Zu Beginn möchte ich gern eine wichtige Unterscheidung treffen. Wenn wir über „digitales Theater“ und „digitale Räume“ sprechen: Meinen wir das Inszenieren rein virtueller, ‚körperloser‘ Online-Bühnen? Oder liegt die Herausforderung nicht vielmehr darin, Bühnen zwischen materiellen, theatralen und virtuellen Räumen zu gestalten? In meiner gesamten bisherigen Arbeit geht es im Grunde um die zweite Variante: Ich arbeite auf der Bühne z.B. mit Sensoren, Video-Projektion, elektronischen Räumen und Robotik und bringe diese Mittel in Verbindung – oder auch in Konfrontation und Reibung – mit neuen Theatermitteln. Es geht um Raumchoreografie und Interaktion. Reine VR-Welten zu gestalten war nie mein Fokus. Daher verstehe ich mich auch als Medienkünstler, der am Theater arbeitet bzw. in Theaterkontexten, wo Interesse für solche Ansätze besteht. Im Übrigen bin ich dafür, dass wir das Theater, den Versammlungsort, als Publikum weiterhin aufsuchen. Ohne sie ersetzen zu wollen, ermöglichen die digitalen Medien, die Ereignisräume des Theaters auf unterschiedliche Weise zu erweitern. Daran zu arbeiten, ist für mich „digitale Szenografie“.

Infolge der Corona-Pandemie haben diese Auseinandersetzungen, auch unterstützt durch das Programm Neustart Kultur, einen unerwarteten Schub bekommen. Wie hast Du den Schwerpunkt für Dein Labor zu Motiontracking gesetzt?

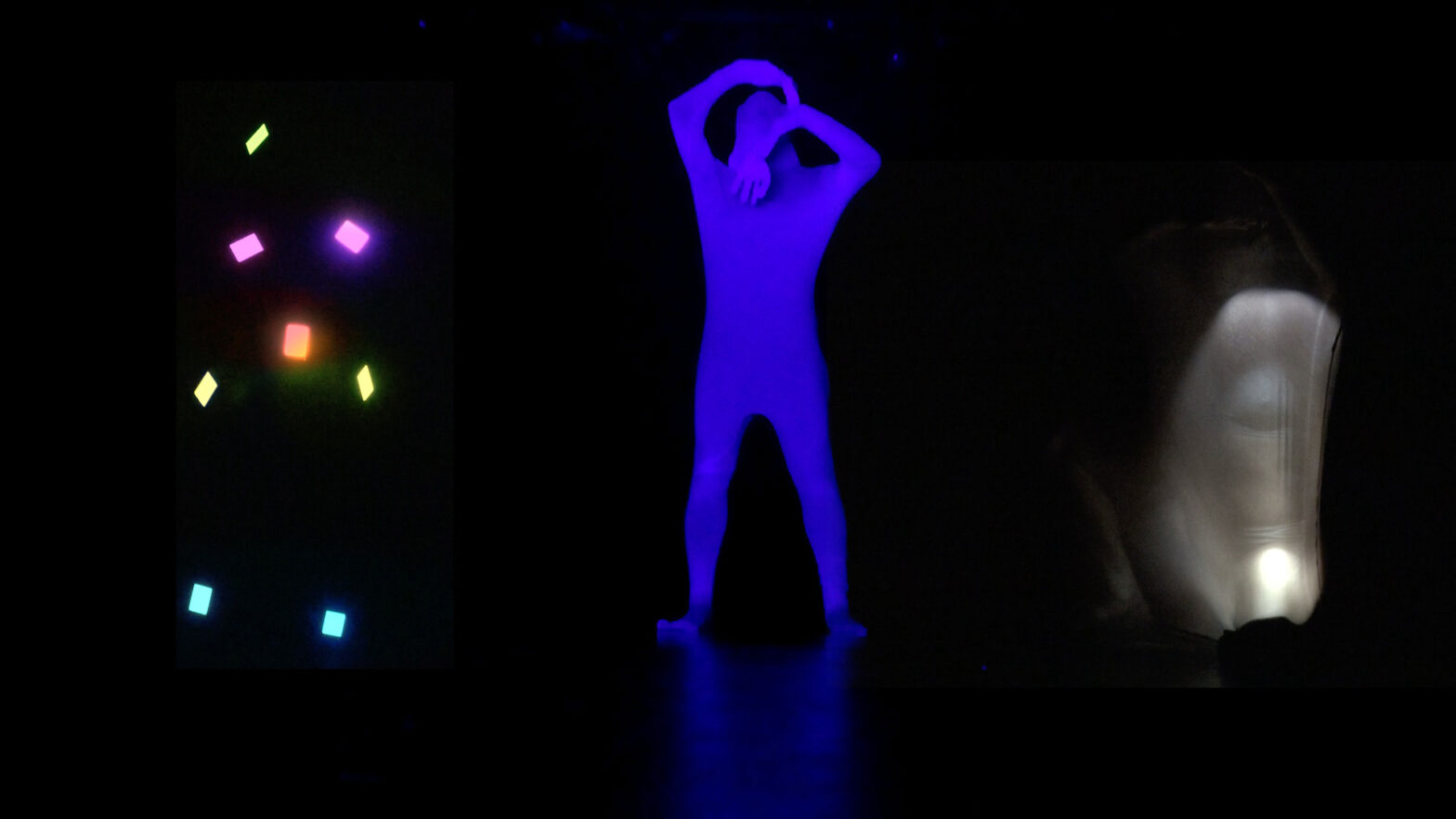

Mein Ansatz, mit interaktiven Systemen auf Bühnen zu arbeiten, war auch hier der Leitgedanke. Neben konkreter Praxis ging es darum, sich zu der Historie und Entwicklungen, die es schon gibt, ins Verhältnis zu setzen. Wir haben uns mit Motion Sensing und Position Tracking befasst, als Grundlage, Körper auf der Bühne zu messen. Zunächst mit Low-Tech-Mitteln wie einfache Schwarz-Weiß-Infrarot-Kameras und der Multimedia-Software ISADORA, die vor rund 20 Jahren nicht von einem Tech-Konzern, sondern von der Künstlergruppe Troika Ranch (2) entwickelt wurde und bis heute immer weiter modifiziert wird. Zudem habe ich ein selbst entwickeltes Motion Sensing-System Corpus mit-gebracht, mit dem man durch Bewegung Licht und Ton erzeugen kann. An den letzten Tagen haben wir – mithilfe von Rokoko Motiontracking-Anzügen, der Software Live Face und dem Motion-Capture-Programm iClone von Reallusion – 3D-Avatare gebaut und versucht, sie in ‚Echtzeit‘ zu bewegen.

Was nimmst Du selbst aus Deinem Szenografie-Labor mit?

Die Teilnehmer*innen waren sehr unterschiedlich: Kostüm- und Bühnenbild-Studierende, langjährige Profis, eine Inspizientin, und sie waren entweder technikaffin oder Neulinge. Wie gesagt, interessiert mich nicht, reale Menschen anhand maximal vieler Daten zu virtualisieren, sondern das Untersuchen von Dynamiken bzw. Loops zwischen Bühnen, unseren Körpern und dem Virtuellen. Seit Kurzem ist die Technik auch für freie Künstler*innen erschwinglich, um 3D-Avatare einzubeziehen.

Die Diskussion mit den Teilnehmenden war sehr anregend – und wie sie das selbst künftig nutzen werden, bleibt natürlich ihnen überlassen. Eines meiner Anliegen war, dafür zu sensibilisieren, wie Technologien unsere Arbeitsweisen verändern und kreative Freiheit erlauben oder auch einschränken.

Lass uns kurz darüber sprechen, was das für Theaterabläufe an Häusern bzw. in der freien Szene bedeuten. Da gibt es Aufholbedarf, diskursiv und strukturell. Das Karlsruher ZKM, gegründet als

„Digitales Bauhaus“ (3), hat – anders als das historische Bauhaus – keine forschende Abteilung für Theater/Tanz, das fand ich immer schade. Deine Forschung blieb dort, aber auch im Theaterkontext lange eher für sich, und dann hast Du in den USA, Bangalore/Indien und anderswo gearbeitet. Jetzt haben wir die Akademie für Theater und Digitalität Dortmund, die digitalDTHG, das theaternetz-werk.digital und unsere (wenngleich nur temporären) Labore. Welche Perspektiven siehst Du?

Als Medienkünstler auf der Bühne setze ich eigene Projekte um (mit eingeworbenen Mitteln) oder arbeite an Theatern in wechselnden Teams. Technologie und Equipment aus früheren Projekten, finanziert aus Förderprogrammen wie z.B. tanz:digital, NPN Stepping Out oder TakeHeart, kann ich oft mitbringen. Daher braucht es aus meiner Sicht erstmal nicht viel: eine neutrale Bühne oder Black Box, Trusses und Grids an der Decke, WLAN und einigermaßen schnelle PCs, auf denen komplexe 3D-Applikationen laufen können. Und es braucht Zeit und Freiräume, die im deutschen Theater mit seinem Repertoirebetrieb allerdings knapp sind, und mehr Verständnis für die Besonderheit künstlerischer Prozesse im Umgang mit interaktiven Technologien. Ohne Witz: es kommt vor, dass ich beim Proben nur die Mittagspausen der Lichteinrichtung als Zeitfenster bekomme. In gewachsenen Teamhierarchien haben Medienkünstler*innen noch keinen Platz. Unsere Technik muss aber genau eingerichtet und kalibriert werden. Interaktive Systeme stellen veränderte Anforderungen an Teams und Gewerke. Sie können nicht einfach ‚fertig‘ eingesetzt werden, ohne mit Regie, Licht, Ton und den Ensembles ausreichend zu proben. Software muss vor den Proben geschrieben werden, und oft werden Anwendungen bei den Proben modifiziert. Da gibt es noch einige Missverständnisse, hinzu kommt der Premierendruck. Doch ich mache auch andere, positive Erfahrungen.

Zum Beispiel?

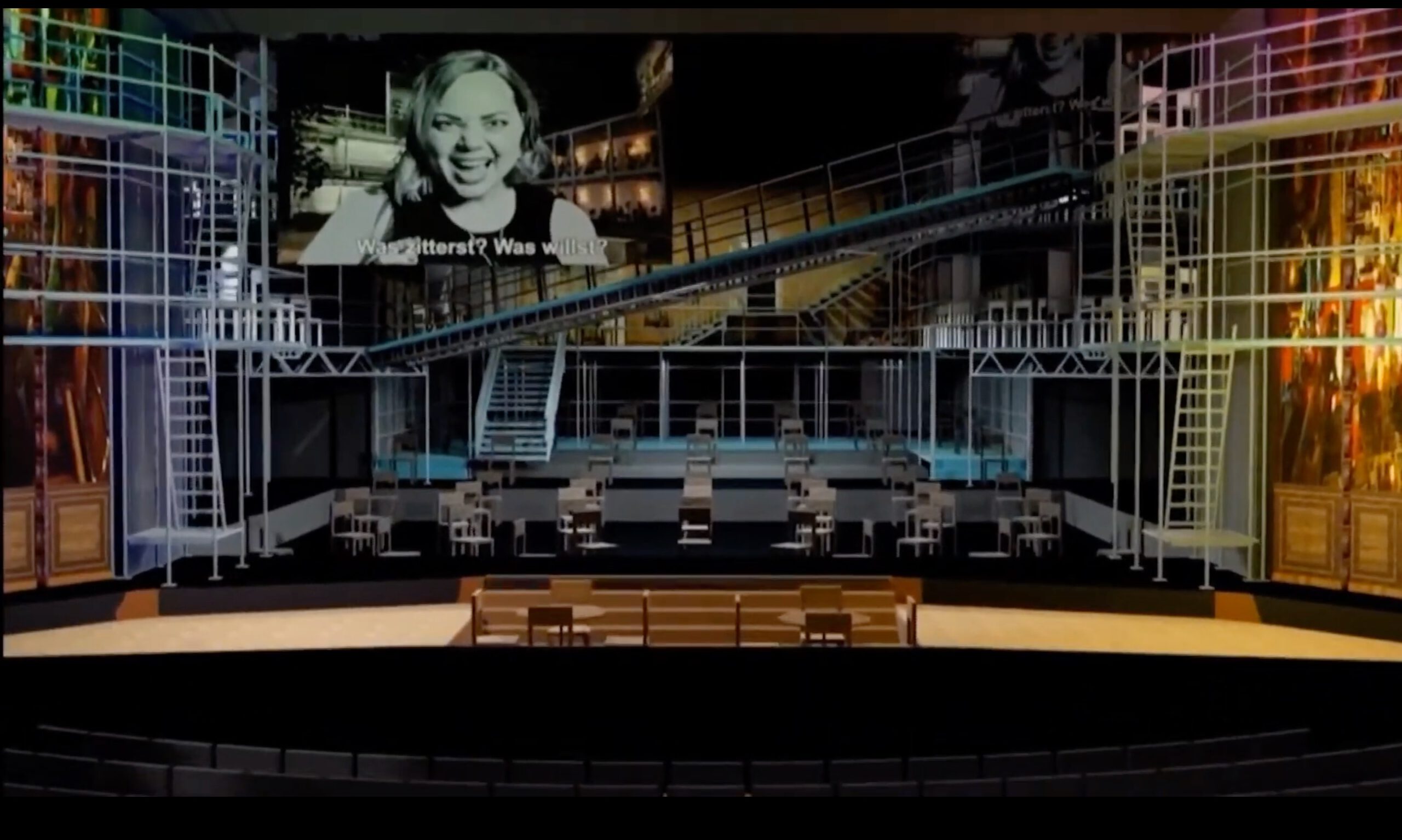

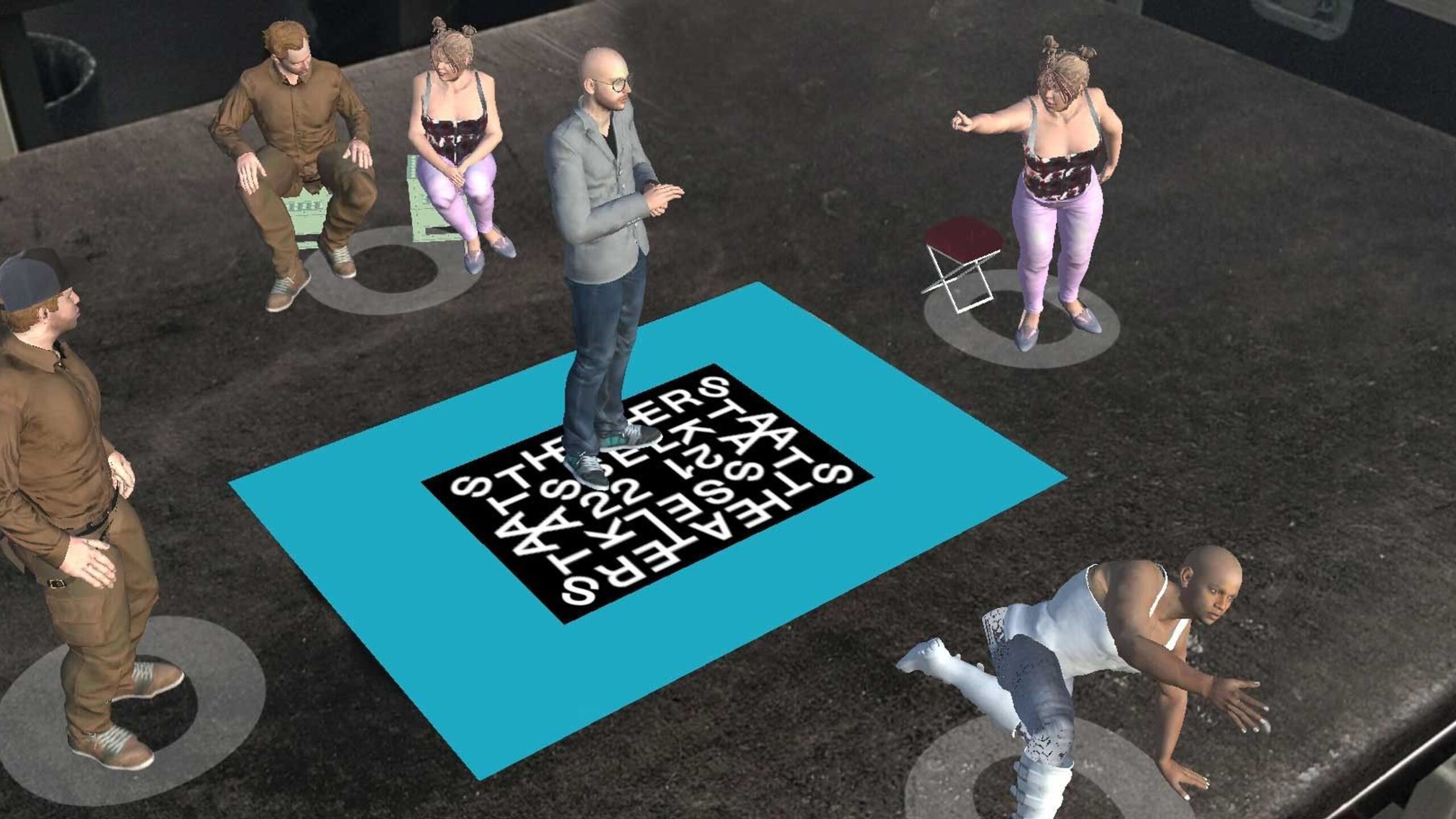

Schon länger zurück: Bei einer choreographischen Arbeit von Davide Bombana im Bühnenbild von Michael Simon und mit Musik von Heiner Goebbels sollten die Bewegung der Tänzer im Video per Max/MSP und Jitter live ein 3D Szenario (4) generieren. Die IT-Abteilung der Bayerischen Staatsoper hat dafür eigens einen zweiten Computer gekauft und mich enorm unterstützt. Ein aktuelles Beispiel, anderer Ansatz: Die „Raumbühne Pandaemonium“ am Staatstheater Kassel 2021, die von Sebastian Hannak auf Modzilla Hubs komplett virtuell entworfen wurde. Bei den Proben wurde sie für das Team und später auch für Publikum digital zugänglich gemacht, und ich habe mit Sebastian dafür eine AR App entwickelt. Vor der Premiere im Opernhaus haben wir die Sänger*innen der neue „Wozzeck“-Inszenierung in 3D aufgenommen (damals mit dem niedrigschwelligen, in Russland entwickelten Motion Capture-Programm IPI-Soft) und die Avatare dann mit dem Gesang verknüpft.

Die Szenen hätten sogar auf die virtuelle Bühne in Modzilla Hubs eingespielt werden können. Das hat leider aber aus Zeitgründen nicht mehr geklappt. Das Projekt war Angebot, PR-Idee, ein ‚theatraler

Gruß‘, den wir in Corona-Zeiten an ein Publikum schickten, das vor seinen iPhones oder iPads zu Hause quasi eine Oper auf dem Küchentisch erlebt. Man kann darin auch eine Erweiterung von

Theater sehen, mit digital-szenografischen Mitteln.

zu „Wozzeck“, 2021. Screenshots © Staatstheater Kassel und Chris Ziegler

Das Publikum setzt keine VR-Brillen auf, sondern soll beim Erleben der „Oper auf dem Küchentisch“ fühlbar im materiellen Raum, in realen Umgebungen verankert bleiben. Das hat auch einen sozialen Aspekt: Ziel ist nicht, die Theaterbühnen gegen digitale Bühnen einzutauschen, sondern zu fragen, wie man sie erweitern kann – virtuell und auch im Radius, in dem man Öffentlichkeit erreicht. In den Performance Design-Studies gibt es den Begriff „expanded Scenography“ (siehe auch: J. McKinney, S. Palmer (Eds.): Scenography Expanded. London, New York: Bloomsbury-Methuen 2017). Ich muss an Bert Neumann denken, der, wenngleich anders, für einen erweiterten Szenografie-Begriff eintrat und zudem verlangte, „wie ein bildender Künstler am Theater“ zu arbeiten. Du sagst, Du willst „wie ein Medienkünstler am Theater“ arbeiten.

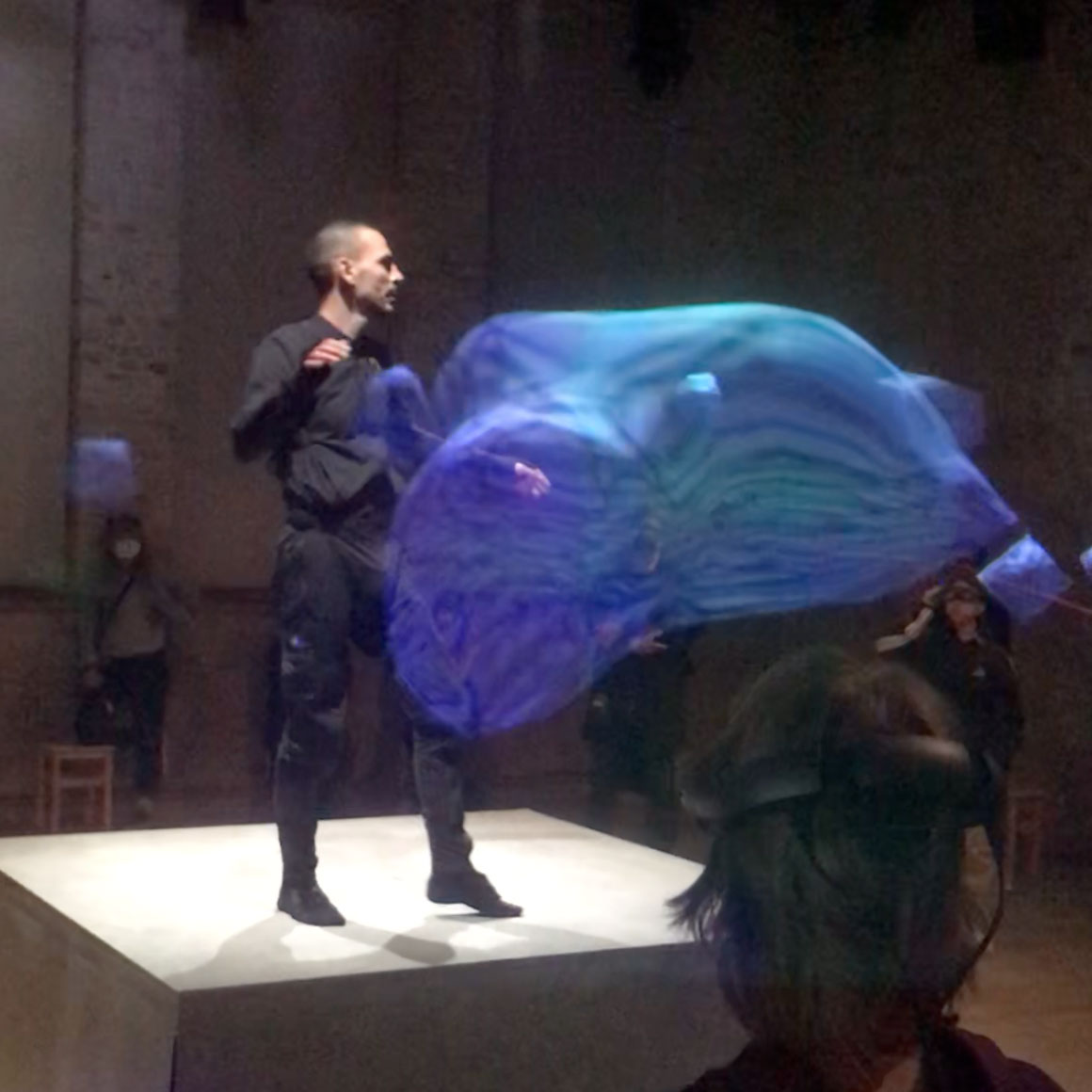

Mein Wunsch ist, dass Szenografen mit hochspeziellen Technologien an den Häusern experimentieren können, auch langfristiger. Und wie wäre es, wenn Theaterleute, Regisseurinnen, Choreografinnen wiederum mit interaktiven Systemen, z.B. dem von mir entwickelten System forest 3 (5), forschen und etwas machen? In der Logik wäre das vergleichbar mit den Raumbühnen und -installationen von Bert Neumann oder Sebastian Hannak: ein szenografisches Dispositiv, mit dem alle für gewisse Zeit arbeiten und vielleicht ganz unterschiedliche Stücke entstehen. Ich stelle mir vor, dass das auch mit digitalen Mitteln funktioniert. Zudem finde ich gut, wenn wir Erfahrungen und Toolkits untereinander austauschen. Zurzeit arbeite ich im Dock11 Berlin mit Oliver Proske von Nico and the Navigators zusammen. Seit einer Produktion im Rahmen von Bauhaus100 arbeitet er mit der AR- Technologie Magic Leap. Diese AR-Brillen legen ihr Bild über das reale Sichtfeld des/der Betrachter*in. VR-Brillen dagegen blockieren das Sichtfeld. Wir beide arbeiten jetzt mit AR-Brillen und nutzen dafür Motiontracking: Oliver entwickelte einen 3D-Server, die AR-Loopmachine. Mich interessiert: Wie kann man Daten von Live-Performern in diese 3D-Welt integrieren, sodass beides – materielle Bühne, Körper und die virtuelle Architektur und Körperlichkeit – sich synchron, ohne Zeitverzug, überlagern? Das ist Thema meiner Arbeit PopUp Stage ARENA (6): in der Live-Aktion eines Tänzers entsteht ein virtuelles Kostüm, das mit einem Motiontracking-Anzug auf der Bühne vor den Augen des Publikums erzeugt wird. Das ist dann beides, Theater und digitale Magie!

Eine letzte Frage. Das alles klingt vielversprechend und zukunftsweisend, doch diese Systeme und Technologien verbrauchen Strom und Ressourcen; hinzu kommt der Technikschrott, der jährlich weltweit entsteht und zu dem sie beitragen. Wenn wir also mit und über Szenografie forschen, wie gehen wir mit der Frage der ökologischen Nachhaltigkeit um?

Diese Frage können wir nicht ignorieren, auch wenn der Verbrauch im Theater im Vergleich zu anderen Bereichen sicher gering ist. Für mich selbst kann ich sagen, dass ich nie Technologie gekauft habe, die nur für eine Produktion genutzt wurde. Ich bin freier Künstler und es ist so, dass ich die Technologien, die auch mit mir mitreisen, als mein Werkzeug und Instrument betrachte – ähnlich wie ein Musiker, der sein Instrument wertschätzt und pflegt. Der Weg sollte nicht über Kleinklein-Denken, sondern über das Diskutieren von Konzepten laufen. Dass man Material und Teile aus abgespielten Bühnenbildern wiederverwendet, finde ich wichtig. Als Medienkünstler am Theater interessiert mich vor allem aber, digitale Erweiterungen für Bühnenbilder zu entwickeln – als Instrument, das ich ästhetisch, inhaltlich und technisch immer wieder so umbauen und weiterentwickeln kann, wie ich es als Szenograf oder Regisseur für eine neue Produktion brauche. Zudem will ich gern anregen, dass andere meine Systeme benutzen, z.B. das schon erwähnte Licht-Robotik-System forest 3. Und dass wir uns überhaupt mehr austauschen. Auch das wäre nachhaltig, ich sehe da viel Forschungs- und Gestaltungspotential.

Chris Ziegler ist Künstler, Regisseur und Performer im Bereich der darstellenden und digitalen Künste. Studium der Architektur und Medienkunst; über 20 Jahre lang assoziierter Künstler am ZKM | Zentrum für Kunst und Medien Karlsruhe mit Schwerpunkt Entwicklung interaktiver Systeme für Theaterbühnen. Seither zahlreiche eigene, international prämierte Theater- und Medienprojekte sowie Kooperationen mit Regisseuren wie u.a. Michael Simon. 2013–21 lehrte er an der Arizona State University, USA, im Studiengang Interactive Media; seit 2021 lebt und arbeitet er wieder in Europa, u.a. am DOCKdigital Lab, Berlin. Aktuelle Projekte: die KI-Theaterproduktion ANA, unterstützt von der VW-Kulturstiftung und weiteren Förderern.

Literatur:

- https://troikatronix.com. Zur Geschichte von ISODARA s.a. Mark Coniglio / Troika Ranch: „Dance-Tech Archaeology“ (Public Lecture, 30.06.2022), www.youtube.com/watch?v=snK3cUVTOkE

- Vgl. Geschichte & Mission Statement, https://zkm.de/de/das-zkm. Zum Schwerpunkt Tanz/Performance – Dokumentation / Ausstellbarkeit (P. Weibel), https://zkm.de/de/forschung-produktion/schwerpunkte

- Ballettabend Bombana / Simon / Godani, Teil I und II: „Century Rolls” und „In the Century of Last Things” (2006), www.movingimages.de/?type=performing&txt_id=58&searchterm=&lng=eng

- J. McKinney, S. Palmer (Eds.): Scenography Expanded. London, New York: Bloomsbury-Methuen 2017

- Kurzvideos zu forest 2 bzw. 3, www.movingimages.de/?type=research&txt_id=135&searchterm=&lng=eng

- https://dock11-berlin.de/theater/programm/spielplan/popup-stage-arena